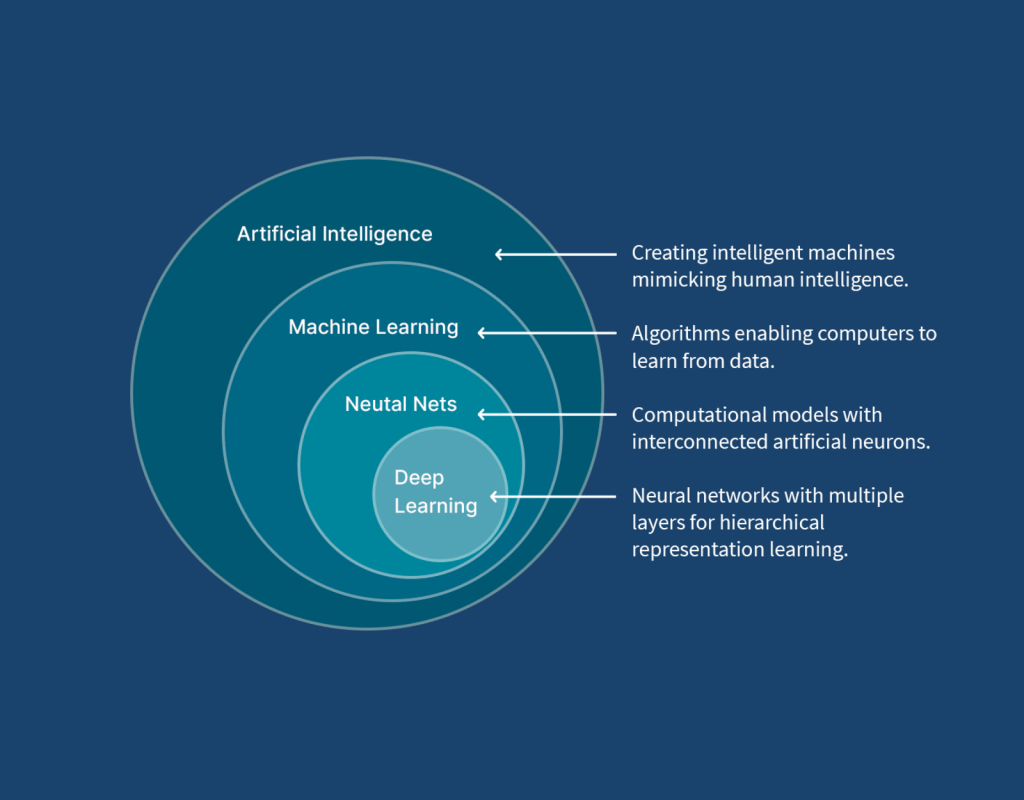

A inteligência artificial (AI) está revolucionando setores como saúde, segurança cibernética, finanças, automação e tecnologia, impulsionando avanços significativos em aprendizado profundo (deep learning) e machine learning. No entanto, o treinamento de modelos de AI exige altíssima capacidade de processamento, e as GPUs (Unidades de Processamento Gráfico) se tornaram um componente essencial para essa tarefa.

Mas por que GPUs são tão importantes no treinamento de AI? E por que CPUs (Unidades Centrais de Processamento) não são suficientes para esse tipo de trabalho? Neste artigo do Blog Dolutech, exploramos as razões pelas quais as GPUs são fundamentais para o treinamento de IA e damos exemplos práticos do seu uso.

Por Que AI Exige Tanto Poder de Processamento?

O treinamento de modelos de Machine Learning (ML) e Deep Learning (DL) envolve grandes volumes de cálculos matemáticos complexos, exigindo o processamento de bilhões ou até trilhões de operações matriciais. Modelos como GPT-4, Mistral 7B e Stable Diffusion são compostos por bilhões de parâmetros, o que significa que o treinamento pode levar semanas ou meses em hardware de alto desempenho.

A principal razão pela qual IA exige tanto poder de processamento está relacionada a três fatores principais:

1. Alto Volume de Cálculos Matriciais

Os algoritmos de aprendizado profundo são baseados em redes neurais artificiais, que operam essencialmente com multiplicação e soma de matrizes. Cada camada da rede realiza bilhões de operações matemáticas, especialmente durante a fase de treinamento.

Exemplo: No treinamento de um modelo de reconhecimento de imagem, cada pixel da imagem precisa ser processado e transformado em uma matriz de valores, que será analisada por várias camadas da rede neural.

2. Processamento Paralelo em Larga Escala

As GPUs possuem milhares de núcleos de processamento, permitindo que realizem milhares de cálculos simultaneamente. Isso é essencial para o treinamento de redes neurais, pois cada neurônio da rede pode ser atualizado ao mesmo tempo, acelerando drasticamente o treinamento.

Exemplo: Enquanto uma CPU tradicional pode executar 8 a 64 threads simultaneamente, uma GPU moderna, como a NVIDIA A100, pode processar mais de 8.000 operações ao mesmo tempo.

3. Grandes Volumes de Dados (Big Data)

Os modelos de IA precisam ser treinados com enormes quantidades de dados, frequentemente terabytes de imagens, textos ou vídeos. Esse processo exige alta largura de banda de memória e processamento contínuo para que o modelo consiga identificar padrões nos dados.

Exemplo: O modelo GPT-4 foi treinado com trilhões de tokens de texto, exigindo infraestrutura de ponta com GPUs especializadas, como a NVIDIA H100 e a AMD MI300X.

Por Que GPUs São Melhores Que CPUs para AI?

As GPUs superam as CPUs no treinamento de IA por possuírem arquitetura otimizada para operações paralelas. Aqui estão algumas das principais diferenças:

| Característica | CPU (Processador) | GPU (Placa de Vídeo) |

|---|---|---|

| Número de Núcleos | 4 a 64 núcleos | Milhares de núcleos |

| Execução de Operações | Sequencial | Paralelo |

| Eficiência para IA | Baixa | Alta |

| Consumo de Energia | Menor | Maior, mas otimizado para ML |

| Memória Especializada | Cache L3 e DDR4 | HBM (High Bandwidth Memory) e GDDR6 |

Conclusão: As GPUs podem executar milhares de cálculos simultaneamente, enquanto as CPUs são mais eficientes para tarefas sequenciais e lógicas, como manipulação de dados e execução de sistemas operacionais.

Exemplos de GPUs Utilizadas em AI

1. NVIDIA A100 e H100

- Projetada para Data Centers

- 80 GB de memória HBM2e

- Utilizada para treinamento de modelos como ChatGPT e Bard

Exemplo: Empresas como OpenAI, Google e Microsoft utilizam milhares de GPUs NVIDIA A100/H100 em clusters para treinar modelos avançados de AI generativa.

2. AMD Instinct MI300X

- Alternativa à NVIDIA para IA de alto desempenho

- 128 GB de memória HBM3

- Suporte a grande largura de banda

Exemplo: Algumas startups estão migrando para AMD MI300X para reduzir custos e evitar a alta demanda das GPUs NVIDIA.

3. Apple M2 Ultra (Chip Proprietário)

- Unificação de CPU e GPU em um único chip

- Bom desempenho para IA embarcada

- Uso em IA no próprio dispositivo (on-device AI)

Exemplo: A Apple utiliza GPUs embutidas em chips como o M2 Ultra para melhorar o desempenho de Machine Learning no iPhone e MacBook.

Casos de Uso de GPUs no Treinamento de IA

1. Chatbots e Modelos de Linguagem (LLMs)

Modelos como GPT-4, Mistral 7B e Llama 2 requerem enormes clusters de GPUs para processamento de texto em tempo real.

Exemplo: A OpenAI usa supercomputadores com milhares de NVIDIA H100 para treinar seus modelos.

2. Geração de Imagens (AI Generativa)

Modelos como Stable Diffusion e Midjourney precisam de enorme poder de GPU para renderizar imagens rapidamente.

Exemplo: Artistas usam GPUs RTX 4090 para gerar imagens realistas em segundos.

3. Segurança Cibernética e Análise de Ataques

Empresas de segurança cibernética usam IA para detectar padrões de ataques em redes em tempo real.

Exemplo: Sistemas de detecção de ameaças baseados em AI utilizam GPUs para analisar milhões de logs por segundo.

Conclusão

O treinamento de AI exige enorme poder computacional, e as GPUs são a peça-chave para acelerar esse processo. Sua capacidade de processamento paralelo, combinada com memória de alta largura de banda, permite que modelos de machine learning e deep learning sejam treinados com eficiência.

Seja para chatbots avançados, análise de segurança cibernética ou geração de imagens, as GPUs são indispensáveis no desenvolvimento e evolução da inteligência artificial moderna.

Com a crescente demanda por AI, o futuro aponta para a expansão do uso de GPUs e chips dedicados, como os aceleradores de IA (TPUs, NPUs e FPGAs), otimizando ainda mais o desempenho no treinamento de modelos avançados.

Amante por tecnologia Especialista em Cibersegurança e Big Data, Formado em Administração de Infraestrutura de Redes, Pós-Graduado em Ciências de Dados e Big Data Analytics e Machine Learning, Com MBA em Segurança da Informação, Escritor do livro ” Cibersegurança: Protegendo a sua Reputação Digital”.