Se você deseja que seu site apareça bem posicionado nos resultados de busca do Google, entender o papel do sitemap e do robots.txt é essencial. Esses dois arquivos são fundamentais para garantir que os mecanismos de busca indexem corretamente o conteúdo do seu site, facilitando a visibilidade online e ajudando no SEO (Search Engine Optimization).

Neste artigo do Blog Dolutech, vamos explorar o que são o sitemap e o robots.txt, como eles afetam o ranqueamento do seu site, as vantagens de usar plataformas como WordPress e Joomla que geram esses recursos automaticamente, além de destacar ferramentas úteis para criar e gerenciar esses arquivos. Também vamos abordar os problemas que podem surgir se o sitemap não for lido corretamente e a importância de configurar o firewall adequadamente para não bloquear os robôs de busca.

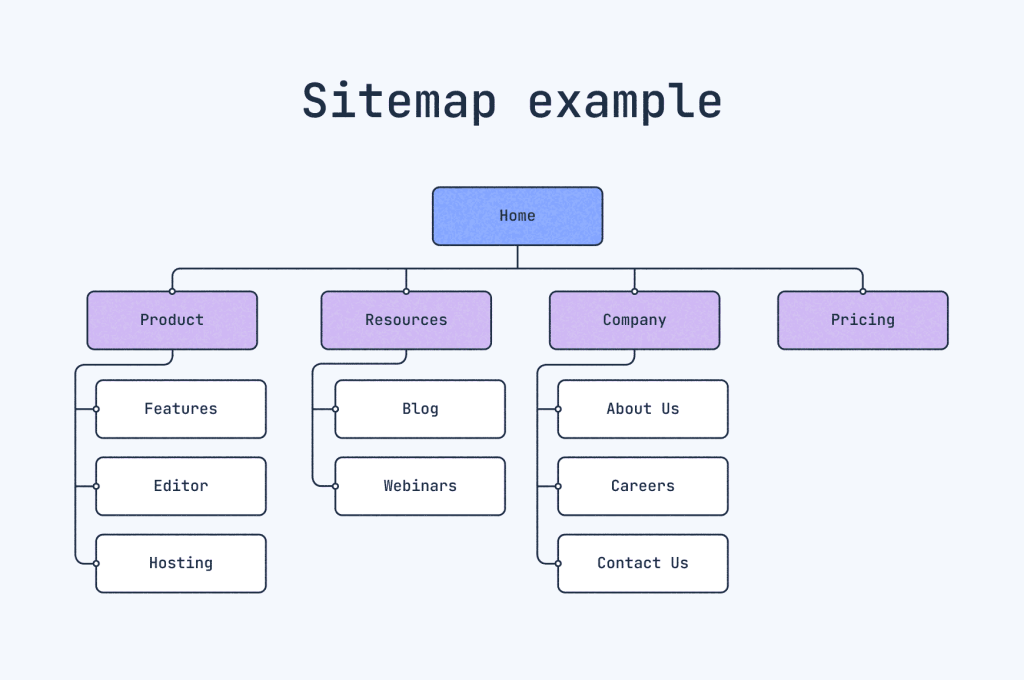

O Que é um Sitemap?

O sitemap é um arquivo XML que lista todas as páginas importantes do seu site e fornece informações sobre a estrutura do conteúdo. Ele ajuda os mecanismos de busca, como o Google, Bing e Yahoo, a entenderem quais páginas devem ser indexadas e com que frequência o conteúdo é atualizado.

Principais Funções do Sitemap:

- Facilita a indexação de páginas novas ou atualizadas.

- Indica a prioridade de páginas específicas para o mecanismo de busca.

- Melhora o ranqueamento ao garantir que todas as páginas relevantes sejam descobertas.

- Auxilia na indexação de conteúdos multimídia, como imagens e vídeos.

Exemplo de Sitemap XML:

<?xml version="1.0" encoding="UTF-8"?>

<urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">

<url>

<loc>https://www.seusite.com/</loc>

<lastmod>2024-01-31</lastmod>

<changefreq>daily</changefreq>

<priority>1.0</priority>

</url>

<url>

<loc>https://www.seusite.com/blog/artigo-importante</loc>

<lastmod>2024-01-29</lastmod>

<changefreq>weekly</changefreq>

<priority>0.8</priority>

</url>

</urlset>O Que é o Robots.txt?

O robots.txt é um arquivo de texto localizado na raiz do seu site que informa aos robôs dos mecanismos de busca quais páginas ou seções do site eles podem ou não acessar. Ele é essencial para controlar a indexação de conteúdos sensíveis ou desnecessários.

Principais Funções do Robots.txt:

- Permite ou bloqueia o acesso de robôs a partes específicas do site.

- Evita o ranqueamento de páginas duplicadas ou irrelevantes.

- Protege áreas privadas ou páginas em desenvolvimento de serem indexadas.

- Reduz o consumo de banda, impedindo que bots acessem arquivos grandes ou desnecessários.

Exemplo de Robots.txt:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://www.seusite.com/sitemap.xmlExplicação:

User-agent: *indica que a regra se aplica a todos os robôs.Disallow: /wp-admin/impede que bots acessem a área administrativa do WordPress.Allow: /wp-admin/admin-ajax.phppermite o acesso a scripts necessários para o funcionamento do site.Sitemap:informa a localização do sitemap para facilitar a indexação.

A Importância do Sitemap e Robots.txt para o SEO

1. Melhoria na Indexação de Páginas

Com um sitemap bem configurado, você garante que o Google e outros mecanismos de busca encontrem e indexem todas as páginas importantes do seu site, incluindo novos conteúdos que foram adicionados recentemente.

Já o robots.txt ajuda a controlar o que será indexado, evitando que páginas de teste, duplicadas ou sensíveis apareçam nos resultados de busca, o que poderia prejudicar seu ranqueamento.

2. Vantagens de Usar Plataformas como WordPress e Joomla

Plataformas como WordPress e Joomla facilitam muito o gerenciamento do sitemap e do robots.txt, já que geram esses arquivos automaticamente.

WordPress:

O WordPress, especialmente com plugins como Rank Math ou Yoast SEO, gera automaticamente sitemaps atualizados e permite configurar facilmente o robots.txt.

Vantagens do WordPress:

- Atualização automática do sitemap sempre que um novo post é publicado.

- Interface simples para editar o robots.txt.

- Integração direta com o Google Search Console.

Joomla:

O Joomla também possui extensões como o OSMap que geram sitemaps automaticamente e permitem gerenciar o robots.txt.

Vantagens do Joomla:

- Fácil integração com extensões de SEO.

- Controle avançado sobre o que será indexado.

- Suporte a sitemaps de imagens e vídeos.

Ferramentas Online para Gerar Sitemaps

Se você não usa plataformas como WordPress ou Joomla, existem diversas ferramentas online que facilitam a criação do sitemap e do robots.txt:

- XML-Sitemaps – https://www.xml-sitemaps.com

- Screaming Frog SEO Spider – https://www.screamingfrog.co.uk/seo-spider/

- Yoast SEO Generator – https://yoast.com

- Rank Math – https://rankmath.com

- Small SEO Tools – https://smallseotools.com/xml-sitemap-generator/

Essas ferramentas permitem gerar sitemaps automaticamente e até validar o arquivo antes de enviá-lo para o Google.

Problemas Causados por Erros no Sitemap e Robots.txt

1. Sitemap Não Está Sendo Lido Corretamente

Se o sitemap parar de ser lido corretamente pelos robôs do Google, seu site pode ter páginas não indexadas, o que significa que novos conteúdos não aparecerão nos resultados de busca. Isso pode afetar diretamente o tráfego orgânico e prejudicar o ranqueamento.

Como identificar:

- Verifique o Google Search Console para erros de leitura no sitemap.

- Use ferramentas como TechnicalSEO para validar o sitemap.

2. Robots.txt Bloqueando Robôs Indevidamente

Configurações erradas no robots.txt podem bloquear completamente o acesso de mecanismos de busca ao seu site, prejudicando o SEO. Isso acontece, por exemplo, quando regras como Disallow: / são aplicadas por engano, bloqueando o site inteiro.

Como identificar:

- Use a ferramenta “Inspeção de URL” do Google Search Console para verificar se o site está sendo bloqueado.

- Utilize o Robots.txt Tester para garantir que as regras estejam corretas.

Cuidado com Firewalls e Bloqueios Involuntários

1. Firewalls Podem Bloquear Robôs de Busca

Configurações rígidas em firewalls podem acidentalmente bloquear o acesso dos bots de mecanismos de busca, como o Googlebot. Isso pode ocorrer, por exemplo, quando regras de segurança são configuradas para impedir acessos automatizados, sem considerar os bots de busca legítimos.

Como Evitar Isso?

- Garanta que o seu firewall permite o acesso de robôs legítimos como o Googlebot, Bingbot e outros.

- Configure exceções no firewall para os endereços IP dos principais mecanismos de busca.

- Teste periodicamente o acesso de robôs usando o Google Search Console.

Se você usa Cloudflare no seus sites, cuidado pois algumas aplicações podem acabar bloqueando Boots do indexadores e causar problemas de indexação.

Conclusão

A correta configuração do sitemap e do robots.txt é essencial para garantir que o seu site seja indexado corretamente pelos mecanismos de busca, ajudando a melhorar o ranqueamento e a visibilidade online.

Plataformas como WordPress e Joomla tornam esse processo mais simples, mas é fundamental monitorar constantemente o funcionamento desses arquivos para evitar problemas. Além disso, firewalls mal configurados podem prejudicar o acesso de bots legítimos, impactando negativamente o SEO.

Manter o sitemap atualizado e o robots.txt configurado corretamente são passos cruciais para o sucesso do seu site nos resultados de busca!

Amante por tecnologia Especialista em Cibersegurança e Big Data, Formado em Administração de Infraestrutura de Redes, Pós-Graduado em Ciências de Dados e Big Data Analytics e Machine Learning, Com MBA em Segurança da Informação, Escritor do livro ” Cibersegurança: Protegendo a sua Reputação Digital”.